بهبود سرعت ایندکس شدن صفحات جدید

آیا از انتظار برای ایندکس کردن محتوای جدید سایت توسط گوگل خسته شده اید؟ ما به شما کمک میکنیم دلایل آن را دریابید و برای رفع آن اقدام کنید.

نمایه سازی یا همان ایندکس کردن فرآیند دانلود اطلاعات از وب سایت شما، دسته بندی آن ها و ذخیره آن ها در پایگاه داده است.

صفحاتی که دراین فرایند قرارداده نشده اند، نمیتوانند در نتایج جستجو ظاهر شوند.

اهمیت افزایش سرعت ایندکس کردن صفحات سایت و راهکارهای بهبود سرعت ایندکس شدن محتوای جدید را در این مقاله از بلاگ سلکتک می خوانید.

اهمیت افزایش سرعت ایندکسینگ صفحه جدید

بیایید فرض کنیم شما اخیراً یک صفحه جدید به وبلاگ خود اضافه کرده اید. در پست جدید خود، در مورد یک موضوع پرطرفدار بحث می کنید، به این امید که ترافیک جدید زیادی برای شما فراهم کند.

اما قبل از اینکه بتوانید عملکرد صفحه را در جستجوی گوگل ببینید، باید منتظر بمانید تا ایندکس شود.

بنابراین، باید بدانید این فرآیند دقیقا چه میزان زمان میبرد و از چه زمانی باید نگران باشید که عدم نمایه سازی ممکن است نشانه مشکلات فنی در سایت شما است؟

بدین ترتیب میتوانید سریعتر برای رفع مشکلات سئو سایت اقدام کنید تا بتوانید جایگاه بهتری در نتایج گوگل کسب کرده و ترافیک بیشتری از سمت گوگل بدست آورید.

خرید ترافیک سایت برای صفحات نیز یکی دیگر از راه هایی است که به گوگل اهمیت زیاد و حضور کاربر در آن صفحه را نشان میدهد و صفحات سایت را سریعتر در نتایج گوگل رتبه بندی میکند.

روند نمایه سازی صفحات سایت توسط گوگل

فهرست گوگل برای نمایه سازی صفحات سایت شامل صدها میلیارد صفحه وب است و بیش از 100 میلیون گیگابایت حافظه را اشغال می کند.

علاوه بر این، گوگل تعداد صفحاتی را که در یک وب سایت می توانند ایندکس کنند را محدود نمی کند. در حالی که برخی از صفحات ممکن است در صف نمایه سازی اولویت داشته باشند، صفحات معمولاً مجبور نیستند برای indexing با هم رقابت کنند.

با این حال گوگل بیان می کند که هر صفحه ای که توسط خزنده ها پردازش می شود، گاهی اوقات ایندکس نمی شود .

در ژانویه 2021، جان مولر، این موضوع را توضیح داد و فاش کرد که این موضوع کاملاً طبیعی است که گوگل همه صفحات یک وب سایت بزرگ را ایندکس نمی کند .

او توضیح داد که چالش پیش روی گوگل تلاش برای ایجاد تعادل بین تمایل به فهرست بندی هرچه بیشتر محتوا با تخمین مفید بودن آن برای کاربران موتورهای جستجو است.

بنابراین، در بسیاری از موارد، فهرست نشدن یک محتوای معین، انتخاب استراتژیک گوگل است.

مهم ترین دلیل گوگل برای ایندکس نکردن مطالب

گوگل نمیخواهد صفحاتی که index میکند، شامل صفحاتی با کیفیت پایین، محتوای تکراری یا صفحاتی باشد که بعید است توسط کاربران جستجو شوند. بهترین راه برای جلوگیری از هرزنامه از نتایج جستجو ایندکس نکردن آن مطلب است.

اما تا زمانی که پستهای وبلاگ خود را با ارزش و مفید نگه دارید، همچنان ایندکس باقی میماند.

در نتیجه، تا زمانی که محتوا و مطالب جدید سایت، برای کاربران مفید باشد، شما به مشکل خاصی در روند indexing نخواهید خورد.

اما گاهی اوقات به دلایل دیگری صفحه نمایه سازی نمیشود. در ادامه بیشتر راجب به آن صحبت میکنیم.

آیا حتما صفحه سایت ایندکس می شود؟

جواب این سوال قطعی نیست و به عوامل گوناگونی بستگی دارد.

ایندکس شدن یک صفحه ممکن است از چند ساعت تا چند هفته طول بکشد. گوگل در ابتدا میخواهد که بیشتر محتوای خوب را ظرف حدود یک هفته انتخاب و نمایه سازی کند.

تحقیقات نشان میدهد که به طور متوسط 83 درصد از صفحات در هفته اول انتشار ایندکس و در گوگل فهرست می شوند.

برخی از صفحات باید تا هشت هفته منتظر بمانند تا ایندکس شوند. البته این فقط برای صفحاتی که در نهایت ایندکس می شوند صدق می کند.

برخی صفحات مشکلات خاصی دارند و ممکن است گوگل آنها را ایندکس نکند.

تاثیر بودجه خزش سایت در افزایش سرعت ایندکس محتوا

برای اینکه صفحه جدیدی در سایت کشف و نمایه سازی شود، Googlebot باید سایت را مجدد خزش کند.

هر چند وقت یکبار Googlebot وبسایت شما را بازیابی میکند، که مطمئناً این موضوع بر سرعت ایندکس شدن صفحه جدید شما تأثیر میگذارد و این بستگی به ماهیت محتوا و دفعات بهروزرسانی آن دارد.

وبسایتهای خبری که محتوای جدید منتشر میکنند، اغلب نیاز به بازیابی و خزیدن مکرر دارند. می توان گفت که آنها سایت هایی با تقاضای خزش بالا هستند.

عوامل تعیین کردن بودجه خزش توسط گوگل

گوگل به طور خودکار تعیین می کند که سایت تقاضای خزیدن کم یا زیاد دارد. در طول خزیدن اولیه، بررسی میکند که وبسایت درباره چه موضوعاتی است و آخرین بار چه زمانی بهروزرسانی شده است.

تصمیم به خزیدن در سایت کم و بیش ربطی به کیفیت محتوا ندارد و در اصل عامل تعیین کننده تعداد تخمینی به روز رسانی ها در سایت است.

دومین عامل مهم میزان خزیدن موفق است. این عامل به تعداد درخواستهایی است که Googlebot میتواند بدون اینکه سرور شما را تحت تأثیر قرار دهد، انجام دهد.

اگر سایت را روی سروری با پهنای باند کم میزبانی کنید و ربات گوگل متوجه سرعت کند سرور شود، سرعت خزیدن را تنظیم و کاهش میدهد.

از طرف دیگر، اگر سایت به سرعت به درخواست گوگل بات پاسخ دهد، محدودیت افزایش می یابد و Googlebot می تواند آدرس ها و صفحات بیشتری را بخزد.

نحوه مشخص شدن میزان بودجه خزش

از آنجایی که نمایه سازی زمان می برد، می توان تعجب کرد که این زمان را دقیقاً صرف چه کاری میکند؟

چگونه اطلاعات وب سایت شما در فهرست گوگل طبقه بندی و درج می شود؟

حال دررابطه با نحوه مشخص شدن بودجه خزش و ایندکسینگ توسط گوگل بات صحبت میکنیم.

یافتن محتوا جدید

Googlebot باید در مرحله اول محتوا و آدرس های جدید را درون سایت مشخص کند.

این روند به این صورت است که:

- دنبال کردن پیوندهای داخلی که در سایر صفحات وبلاگ خود ارائه کرده اید.

- دنبال کردن پیوندهای خارجی ایجاد شده توسط افرادی که محتوای جدید شما را مفید می دانند و یا در شبکه های اجتماعی یا دیگر سایت ها به اشتراک گذاشته میشوند.

- بررسی نقشه سایت (XML) که در سرچ کنسول آپلود کرده اید.

حال صفحه پیدا شده است به این معنی است که گوگل از وجود و آدرس آن مطلع است.

خزیدن Googlebot

خزیدن فرآیند بازدید از آدرس و واکشی محتویات صفحه است.

گوگل بات در حین خزیدن، اطلاعاتی را در مورد موضوع اصلی یک صفحه مشخص، فایلهایی که این صفحه شامل آنها است، کلمات کلیدی روی آن و غیره جمعآوری میکند.

پس از یافتن لینک ها در یک صفحه، خزنده های گوگل آنها را دنبال کرده و چرخه ادامه می یابد.

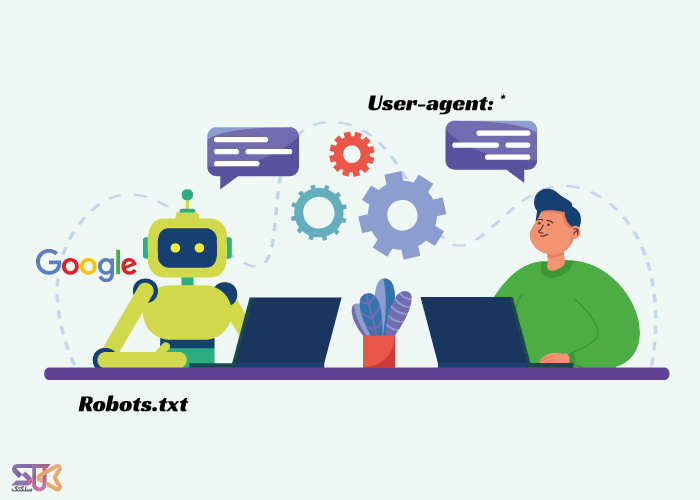

مهم است که به خاطر داشته باشید که Googlebot از قوانین تنظیم شده توسط robots.txt پیروی می کند تا صفحات مسدود شده توسط دستورالعمل هایی را که در آن فایل ارائه می دهید، برای خزیدن و نمایه سازی، استفاده نکنند.

رندر و لود صفحه توسط Googlebot

رندر صفحه باید انجام شود تا Googlebot محتوای جاوا اسکریپت، تصاویر، فایل های صوتی و تصویری را لود کند.

این نوع فایلها همیشه برای گوگل یک مرحله بالاتر از لود HTML است.

فایل HTML اولیه یک وب سایت با پیوندهایی به مطالب دیگر یک دستور است.

تمام منابع وب سایت، مانند CSS، فایل های جاوا اسکریپت، تصاویر و ویدیوها، اجزای لازم برای ظاهر نهایی وب سایت هستند.

هنگامی که وب سایت به این حالت می رسد، شما با HTML رندر شده سروکار دارید.

اجرای جاوا اسکریپت اولین مرحله رندر است زیرا جاوا اسکریپت مانند دستور العمل در یک دستور عمل می کند.

در گذشتهای نه چندان دور، Googlebot از ایندکس کردن نسخه HTML اولیه یک صفحه استفاده میکرد و به دلیل هزینه و زمانبر بودن فرآیند، رندر جاوا اسکریپت را در ابتدا انجام نمیداد.

صنعت سئو از آن پدیده به عنوان "دو موج نمایه سازی" یاد می کند.

امروزه تقریباً هر وبسایت جدید بهطور پیشفرض مرحله رندر را طی میکند و دیگر نیازی به دو موج نیست.

یکی از اهداف گوگل این است که خزیدن، رندر و نمایه سازی به یکدیگر نزدیکتر شوند.

چطور سرعت ایندکس صفحات سایت را افزایش دهیم؟

شما نمی توانید گوگل را مجبور کنید صفحه جدید شما را ایندکس کند.

اینکه چقدر سریع این اتفاق می افتد نیز خارج از کنترل شماست. با این حال، میتوانید صفحات خود را بهینه کنید تا کاوش و خزیدن تا حد امکان راحت انجام شود.

بدین ترتیب با بهینه سازی بهتر سرعت ایندکس صفحات سایت را افزایش میدهید.

چند نکته مهم و کاربردی برای بهبود سرعت ایندکس صفحه و محتوای جدید را به شما آموزش می دهیم.

بررسی کنید که صفحه قابل ایندکس است

برای ایندکس نگه داشتن صفحات خود دو قانون مهم وجود دارد که باید رعایت کنید:

- شما باید از مسدود کردن آدرس توسط robots.txt یا دستورالعمل noindex خودداری کنید.

- شما باید با استفاده از تگ کنونیکال (canonical) آدرس صفحه را برای گوگل مشخص کنید.

Robots.txt فایلی است که حاوی دستورالعمل هایی برای روبات های گوگل است که از سایت شما بازدید می کنند.

می توانید از آن برای تعیین کردن اینکه کدام خزنده ها مجاز به بازدید از صفحات یا پوشه های خاص نیستند استفاده کنید. تنها کاری که باید انجام دهید این است که از دستور Disallow استفاده کنید.

نحوه کار فایل روبوت برای indexing

اگر نمیخواهید روباتها از صفحات و فایلهای موجود در پوشهای با عنوان “example” بازدید کنند، فایل robots.txt شما باید حاوی دستورالعملهای زیر باشد:

User-agent: *

Disallow: /example/

گاهی اوقات، ممکن است به اشتباه Googlebot را از فهرست کردن صفحات ارزشمند مسدود کنید.

اگر نگران این موضوع هستید که صفحه شما به دلیل مشکلات فنی ایندکس نشده باشد، حتما باید نگاهی به robots.txt خود بیاندازید.

گوگل بات هیچ یک از صفحاتی که به آن اجازه داده نشده است را نمایه سازی نمیکند.

اگر نیاز دارید صفحه ای از سایت ایندکس نشود، قرار دادن یک دستورالعمل noindex در:

تگ X-Robots در پاسخ هدر HTTP URL صفحه شما است.

تگ Meta robots در بخش <head> صفحه شما است .

مطمئن شوید که این دستورالعمل در صفحاتی که باید ایندکس شوند ظاهر نشود.

نکات مهم در کد کنونیکال برای ایندکسینگ صفحه

همانطور که گفتیم، گوگل می خواهد از فهرست بندی و indexing محتوای تکراری جلوگیری کند. اگر دو صفحه را پیدا کند که شبیه یکدیگر هستند، احتمالاً فقط یکی از آنها را فهرست می کند.

تگ کنونیکال برای جلوگیری از سوء تفاهم ایجاد شد است و فوراً Googlebot را به آدرس اینترنتی که صاحب وبسایت نسخه اصلی صفحه در نظر میگیرد هدایت میکند.

به یاد داشته باشید که صفحه مد نظر و مهم شما، نباید تگ Canonical با آدرس صفحه ی دیگری داشته باشد.

قرار دادن آدرس در نقشه سایت (sitemap)

به کمک سایت مپ شما میتوانید آدرس هایی که میخواهید ایندکس شوند را سریعتر به گوگل معرفی کنید.

داخل سرچ کنسول گوگل و در بخش sitemap شما لیستی از نقشه سایت ها که در آن آدرس صفحات قرار داده است را ارسال میکنید.

با نقشه سایت، کشف صفحات شما برای Googlebot آسان تر می شود و احتمال خزیدن صفحاتی را که در حین دنبال کردن لینک های داخلی پیدا نکرده است را افزایش می دهید.

یک نکته مهم این است که آدرس نقشه سایت را داخل فایل روبوت به شکل زیر مشخص کنید:

Sitemap: https://selectak.com/sitemap.xml

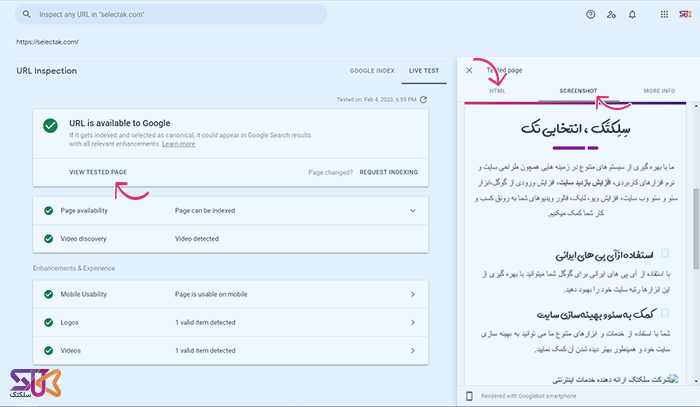

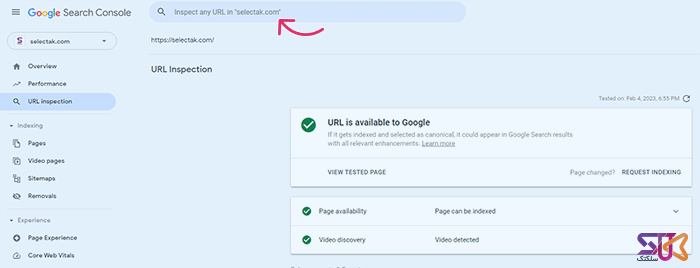

درخواست خزش صفحه در URL inspection

میتوانید با استفاده از ابزار URL inspection داخل سرچ کنسول گوگل، درخواست خزیدن از آدرس ها را به صورت دستی بدهید.

این کار تضمین برای ایندکس شدن صفحه را نمیدهد و شما باید صبر کنید، اما به هر حال یک دستور برای خزش و ایندکس شدن سریعتر به گوگل ارسال میکند.

از API نمایه سازی Google استفاده کنید

Indexing API ابزاری است که به شما این امکان را می دهد که Google صفحات تازه اضافه شده را سریع تر بررسی کند.

به کمک این ابزار، گوگل می تواند فهرست بندی محتوای حساس به زمان را به صورت کارآمدتر برنامه ریزی کند.

متأسفانه، نمیتوانید از آن برای پستهای وبلاگ خود استفاده کنید، زیرا در حال حاضر، این ابزار فقط برای صفحات دارای پیشنهاد شغلی و ویدیوهای زنده در نظر گرفته شده است.

در حالی که برخی از متخصصان سئو از API Indexing برای انواع دیگر صفحات استفاده می کنند که ممکن است در کوتاه مدت برای آنها کار کند اما این تردید وجود دارد که در درازمدت راه حل مناسبی برای شما باشد.

سرعت سایت را افزایش دهید

سرعت سایت یکی از مهم ترین عوامل تاثیرگذار در سئو سایت است. همیشه از پهنای باند سرور و سرعت بارگذاری سایت اطمینان حاصل کنید تا Googlebot نرخ خزیدن برای وب سایت شما را کاهش ندهد.

در صورتی که سرعت سایت شما قابل قبول باشد، صفحات سریعتر نمایه سازی میشوند و جایگاه مناسبی در بین نتایج گوگل کسب خواهید کرد.

اما گاهی اوقات ورودی های گوگل در سایت شما کاهش می یابد و بدین ترتیب شما با سفارش کلیک گوگل از افت این پارامتر تاثیرگذار در سئو جلوگیری میکنید.

برای بهبود سرعت سایت باید در استفاده از ارائه دهندگان هاست اشتراکی خودداری کنید و به یاد داشته باشید که به طور منظم سرور خود را بررسی کنید.

آموزش افزایش سرعت ایندکس شدن صفحه جدید

پیشبینی دقیق اینکه چقدر طول میکشد تا صفحه شما ایندکس شود ویا اصلا آیا این اتفاق خواهد افتاد، دقیقاً غیرممکن است، زیرا Google تمام محتواهایی را که پردازش میکند ایندکس نمیکند.

معمولاً نمایه سازی چند ساعت تا چند هفته پس از انتشار صفحه جدید انجام می شود.

اگر محتوای شما کیفیت قابل قبولی داشته باشد و هیچ مشکل فنی برای نمایه سازی وجود ندارد، در درجه اول باید به نحوه خزیدن Googlebot سایت شما برای ایندکس شدن سریع محتوای تازه نگاه کنید.

دقت داشته باشید که همه عناصر صفحه مانند جاوااسکریپت، عکس ها، سی اس اس و... لود خواهد شد و آنها را در بهینه ترین حالت ممکن قرار دهید.

سرعت لود سایت تاثیر زیادی دارد پس در افزایش سرعت سایت کوشا باشید و از سرورهای خوب استفاده کنید.

وبسایتهایی که بیشتر تغییر میکنند و در نتیجه تقاضای خزیدن بیشتری دارند، بیشتر بازرسی میشوند.

Googlebot را در robots.txt مسدود نکنید زیرا در این صورت صفحات مشخص شده را نمیخزد.

به یاد داشته باشید که گوگل همچنین به متا تگ noindex robots دقت میکند و به طور کلی فقط نسخه ای که در تگ کنونیکال مشخص کرده اید را ایندکس می کند.