توضیحات کامل در رابطه با Robots Meta Tag و X-Robots-Tag

X-Robots-Tag می تواند تاثیر زیادی برای کنترل نحوه خزیدن و نمایه سازی سایت داشته باشد و در بلاگ سلکتک کامل این پاسخ هدر HTTP را توضیح داده ایم.

اگر قصد دارید برخی از صفحات سایت داخل نتایج نمایش داده نشده و ایندکس نشوند، به کمک Robots Meta Tag این کار شدنی است.

در بهترین حالت، اینها هیچ کاری برای هدایت فعالانه ترافیک به سایت شما انجام نمی دهند و در بدترین حالت، می توانند ترافیک را از صفحات مهم تر منحرف کنند.

گوگل به مدیران وبسایتها اجازه میدهد تا به رباتهای موتور جستجو بگویند که چه صفحات و محتوایی را بخزند و چه مواردی را نادیده بگیرند. راه های مختلفی برای انجام این کار وجود دارد، رایج ترین آنها استفاده از فایل robots.txt یا تگ متا ربات است.

باید در استفاده از این متا تگ دقت داشته باشید، در صورت استفاده نادرست برای صفحات مهم سایت باعث خارج شدن از حالت ایندکس صفحه خواهید شد و ورودی گوگل آن صفحه را از دست خواهید داد.

در ادامه محتوا بیشتر در رابطه با این Robots Meta Tag توضیحاتی ارائه خواهیم کرد. با ما همراه باشید.

تفاوت عملکرد robots.txt و متا روبات

Robots.txt یک فایل متنی ساده است که در ریشه وب سایت قرار میگیرد و از پروتکل حذف روبات ها (REP) پیروی می کند.

فایل روبوت به خزندهها دستورالعملهایی به صورت کلی برای سایت ارائه میکند، در حالی که برچسبهای متا روباتها شامل دستورالعملهایی برای صفحات خاص هستند.

برخی از تگهای متا روباتهایی که ممکن است استفاده کنید شامل index هستند که به موتورهای جستجو میگوید صفحه را به فهرست خود اضافه کنند.

در حالی که کد noindex به رباتهای خزنده گوگل میگوید این صفحه را به نمایه سازی نکند یا آن را در نتایج جستجو قرار ندهد. کد follow به موتور جستجو دستور می دهد پیوندهای موجود در یک صفحه را دنبال کند و nofollow به آن میگوید پیوندها را دنبال نکند.

هر دو برچسب robots.txt و meta robots ابزارهای مفیدی برای کنترل بهتر ربات های خزنده گوگل برای صفحه و سایت به حساب می آیند، اما راه دیگری نیز برای آموزش رباتهای موتور جستجو با noindex یا nofollow وجود دارد و آن X -Robots-Tag است.

تگ X-Robots چیست؟

X-Robots-Tag راه دیگری برای کنترل نحوه خزیدن و نمایه شدن صفحات وب شما توسط رباتهای کراول است. به عنوان بخشی از پاسخ HTTP Header به یک URL، نمایه سازی کل صفحه و همچنین عناصر خاص در آن صفحه را کنترل می کند.

و در حالی که استفاده از تگ های متا روبات ها نسبتاً ساده است، استفاده ازX-Robots-Tag کمی پیچیدهتر است.

حال باید نحوه استفاده از این سربرگ را برای شما توضیح دهیم.

چه زمانی باید از تگ X-Robots استفاده کنید؟

به طور کلی هر دستورالعملی که می تواند در متا تگ روبات ها استفاده شود، می تواند به عنوان X-Robots-Tag نیز مشخص شود.

در حالی که میتوانید دستورالعملهای مربوط به robots.txt را در سرفصلهای یک پاسخ HTTP با تگ متا روبات و تگ X-Robots تنظیم کنید، موقعیتهای خاصی وجود دارد که میخواهید از X-Robots-Tag استفاده کنید.

دو مورد از رایجترین مواقع استفاده از آنها:

- زمانی که می خواهید نحوه خزیدن و نمایه شدن فایل های غیر HTML خود را کنترل کنید.

- زمانی که می خواهید دستورالعمل ها را به جای اینکه در سطح صفحه ارائه کنید، در سراسر سایت اعمال کنید.

برای مثال، اگر میخواهید خزیدن یک تصویر یا ویدیوی خاص را مسدود کنید، روش پاسخ HTTP این کار را برای شما آسان میکند.

هدر X-Robots-Tag نیز مفید است زیرا به شما امکان می دهد چندین تگ را در یک پاسخ HTTP ترکیب کنید یا از یک لیست دستورالعمل های جدا شده با کاما برای تعیین دستورالعمل ها استفاده کنید.

برخی از موارد استفاده X-Robots-Tag

شاید شما نمی خواهید صفحه خاصی ذخیره شود و می خواهید بعد از تاریخ خاصی در دسترس نباشد. میتوانید از ترکیبی از تگهای "noarchive" و "unavailable_after" استفاده کنید تا به رباتهای موتور جستجو دستور دهید این دستورالعملها را دنبال کنند.

اساسا، قدرت X-Robots-Tag این است که بسیار انعطاف پذیرتر از تگ متا روبات است.

مزیت استفاده از X-Robots-Tag با HTTP responses این است که به شما امکان میدهد از عبارات منظم برای اجرای دستورالعملهای خزیدن در غیر HTML و همچنین اعمال پارامترها در سطح بزرگتر و جهانی استفاده کنید.

برای کمک به درک تفاوت بین این دستورالعمل ها، دسته بندی آنها بر اساس نوع مفید است. حال دستورها را بر اساس اینکه دایرکتیوهای خزنده هستند یا دایرکتیوهای نمایه ساز دسته بندی میکنیم.

دستورالعمل های نمایه ساز

- تگ متا روبوتس: به شما اجازه می دهد تا موتورهای جستجو را در کنترل نمایش صفحات خاصی در یک سایت در نتایج جستجو و یا جلوگیری از نمایش آن، کمک کند

- Nofollow : به شما امکان می دهد پیوندهایی را مشخص کنید که نباید به اعتبار یا PageRank منتقل شوند.

- X-Robots-tag : به شما اجازه می دهد تا نحوه نمایه سازی انواع فایل های مشخص شده را کنترل کنید.

دستورالعمل های خزنده

- Robots.txt : از دستورالعملهای عامل کاربر، اجازه، غیرمجاز و نقشه سایت استفاده میکند تا مشخص کند رباتهای موتور جستجو در سایت کجا مجاز به خزیدن هستند و مجاز به خزیدن نیستند.

برچسب X-Robots را باید کجا قرار داد؟

فرض کنید می خواهید دسترسی روبات هارا از انواع فایل های خاصی را مسدود کنید. یک رویکرد ایده آل اضافه کردن X-Robots-Tag به پیکربندی آپاچی یا فایل htaccessاست.

X-Robots-Tag را می توان از طریق فایل htaccess به پاسخ های HTTP سایت در پیکربندی سرور آپاچی اضافه کرد.

مثالها و کاربردهای واقعی X-Robots-Tag

برای درک بهتر ایکس-روبوتس-تگ باید در کد به کاربرد آن پی ببرید. فرض کنید میخواستیم موتورهای جستجو انواع فایلهای pdf از سایت را ایندکس نکنند. این پیکربندی در سرورهای آپاچی چیزی شبیه به کد زیر است:

<Files ~ ".pdf$">

Header set X-Robots-Tag "noindex, nofollow"

</Files>

در Nginx، به شکل زیر است:

location ~* .pdf$ {

add_header X-Robots-Tag "noindex, nofollow";

}

حالا فرض کنید می خواهیم از X-Robots-Tag برای جلوگیری از نمایه شدن فایل های تصویری مانند jpg، .gif، .png و غیره استفاده کنیم. شما می توانید این کار را با یک X-Robots-Tag که شبیه زیر است انجام دهید:

<Files ~ ".(png|jpe?g|gif)$">

Header set X-Robots-Tag "noindex"

</Files>

لطفاً توجه داشته باشید که درک نحوه عملکرد این دستورالعمل ها و تأثیر آنها بر یکدیگر بسیار مهم است.

برای مثال، چه اتفاقی میافتد اگر هر دو تگ X-Robots-Tag و متا روباتها زمانی که رباتهای خزنده URL را کشف میکنند، قرار بگیرند؟

اگر آن آدرس از robots.txt مسدود شده باشد، دستورالعملهای نمایهسازی و سرویسدهی خاصی را نمیتوان کشف کرد و دنبال نمیشوند.

اگر قرار است دستورالعملها دنبال شوند، آدرسهای حاوی آنها را نمیتوان از خزیدن منع کرد.

ابزارهای بررسی X-Robots-Tag

برای بررسی X-Robots-Tag در سایت روش های مختلفی وجود دارد که ما چند نمونه از آنها را برای شما آورده ایم.

یکی از روش هایی که می توانید برای تعیین اینکه آیا X-Robots-Tag در حال استفاده است یا خیر، استفاده از افزونه Web Developer در مرورگر کروم است.

با کلیک بر روی افزونه در مرورگر خود و رفتن به بخش "View Response Header" میتوانید صفحههای مختلف را بررسی کنید.

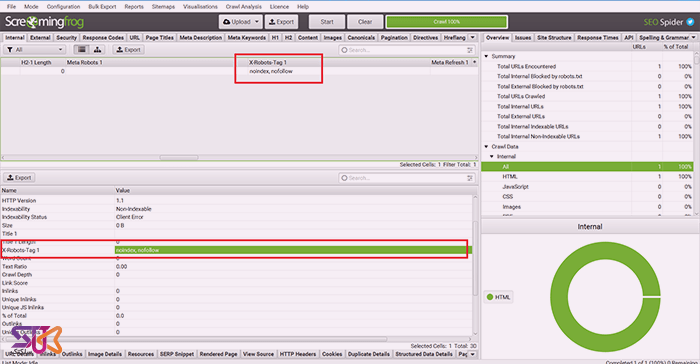

روش دیگری که می توان برای مقیاس بندی به منظور مشخص کردن مشکلات در وب سایت هایی استفاده کرد، نرم افزارScreaming Frog است.

پس از بررسی یک سایت از طریق Screaming Frog، می توانید به بخش "X-Robots-Tag" بروید.

این بخش به شما نشان می دهد که کدام بخش از سایت از برچسب و چه دستورالعمل هایی استفاده می کند.

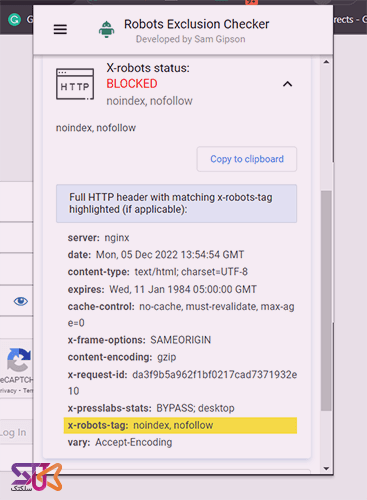

یکی از سادهترین راه برای بررسی، نصب افزونه Robots Exclusion Checker است که اطلاعات X-Robots-Tag را در هر آدرس بررسی کرده و نمایش میدهد.

استفاده از X-Robots-Tags در سایت

درک و کنترل نحوه تعامل موتورهای جستجو با وب سایت شما پایه های بهینهسازی موتورهای جستجو است و X-Robots-Tag ابزار قدرتمندی است که می توانید برای انجام این کار از آن استفاده کنید.

نکته مهم این است که در استفاده از این کدها باید احتیاط کنید و دسترسی صفحات مهم را برای ربات های خزنده مسدود نکنید.